文|經緯創投

在過去這段時間里,GPT-4從初發布、到與Office合體、再到接入插件,每次亮相都引發了AI廣泛和熱烈的討論。許多人表示對GPT-4的到來表示驚喜,也有許多人對其背后的風險感到畏懼。

3月29日,一封來自馬斯克等數千位科技界知名人士的聯名信公開,信中呼吁所有AI實驗室暫停研發比GPT-4更強大的人工智能系統,時間至少6個月。該暫停應當是公開的、可驗證的,所有關鍵參與者都不例外,必要時政府應當介入實施暫停令。他們表示AI將為社會和人類帶來巨大風險,試圖給最近一路狂飆的AI按下暫停鍵。

這種恐懼并非杞人憂天。GPT-4開啟的大模型時代標志著AI的新一層進化,更被視作是AGI時代到來的前奏。就連OpenAI創始人Sam Altman也在采訪中表示,GPT-4的風險讓他有點害怕。

馬斯克等人的聯名信引發軒然大波,經過發酵后,不少知名人士對此進行表態,已經形成了暫停半年派、擁抱未來派、徹底封禁派等數派代表意見。而在個人之外,各國政府也開始考慮如何對AI進行規范。

在馬斯克等人的聯名信中,眾人要求所有AI實驗室和獨立專家,利用6個月的暫停期共同研究制定并且實施針對先進AI設計和開發的安全協議。

面臨AGI的到來,人工智能應該具有哪些倫理價值?如何在創新和規范之間平衡AI治理?國際人工智能協會(AAAI)執行委員會成員、人工智能專家托比·沃爾什(Toby Walsh)在《2062:終結》一書中,對上述問題給出了他的思考。對于AI的規范,或許我們可以從他對于人工智能的看法中,窺見些許方向。以下,Enjoy:

01 AI該不該停?停6個月真的有用嗎?

馬斯克等人的聯名信引發軒然大波,經過發酵后,不少知名人士對此進行表態,已經形成了數派代表意見:

暫停半年派

以馬斯克為首,還有1000多位知名人士表示AI研發應暫停六個月,包括蘋果公司的聯合創始人Steve Wozniak,《人類簡史》的作者Yuval Noah Harari,還有機器學習領域中最杰出的學者等等。他們表示,AI現在在完成某些任務時已經能達到人類智能所完成的水平,如果人類很難完全理解、預測和掌控AI,這個世界將是非常危險的。

此外,他們提出:AI是否為網絡世界帶來大量的假消息和虛假宣傳,是否將替代給人帶來意義感的工作崗位,或是是否會在數量上、智力上等方面超越人類并最終取代人類?在這種情況下,人類的文明還能存在嗎?

圖靈獎得主、深度學習三巨頭之一Yoshua Bengio是這份公開信上的第一個名字。Bengio在29日的新聞發布會上表示:現在的AI已經足夠強大,人們無法辨別電腦屏幕背后的與自己對話的到底是人還是AI。社會、政府和企業的變化速度趕不上AI的進化速度,在AI變得過于強大之前,我們需要時間來想想對策。

聯名信要求所有AI實驗室和獨立專家,利用6個月的暫停期共同研究制定并且實施針對先進AI設計和開發的安全協議,保證企業的設計開發活動經第三方嚴格審計和監督。信中表示,該提議并非想遏制AI發展,而是在更不可預測的黑箱AI模型出世之前做好風險應對。它的結尾寫道,在AI為社會帶來災難之前,我們應當停下來,享受一個長長的AI之夏,不要在沒有準備好的情況下沖進AI之秋。

擁抱未來派

對于此封聯名信,當然也不乏反對者,反對的主要理由是,停6個月也于事無補。

Coursera聯合創始人、AI大牛吳恩達公開表示,除非政府介入,否則暫停GPT的發展并不現實。但如果允許政府出面暫停一個他們并不了解的新興產業的發展,將會對市場活動和創新政策帶來不利影響。最好的方法是在提高透明度、加強審計方面下功夫。AI確有風險,但大部分AI研發團隊對其安全性承擔起了責任,我們無需過于憂慮。

他還指出,GPT-4在教育、醫療保健、食品等領域都帶來很多新的應用,切實幫助了很多人,如果現在要求停止對其訓練,將是非常可怕的。

Meta人工智能研究院研究員田源棟博士認為,AI的發展一旦開始就停不下來了。開弓沒有回頭箭,這就是進化的必然。人類應當向前看,更好地理解LLM(大語言模型),學會適應并利用它的力量,趕上這股浪潮。

物理學家David Deutsch更是在推特上表示,這封信混淆了AI和AGI,看起來就像是在說我們不應該做任何人類無法預測的事情。

本周,Bill Gates也對此表態,表示暫停AI發展無法解決挑戰,他很難想象如何在全球范圍內暫停AI發展,這具體執行起來將非常困難。3月,他曾撰寫以《AI時代已開始》為名的博客,高度肯定人工智能革命的地位。

除了暫停6個月到底有沒有用,很多人還對于是否真的能暫停提出質疑。

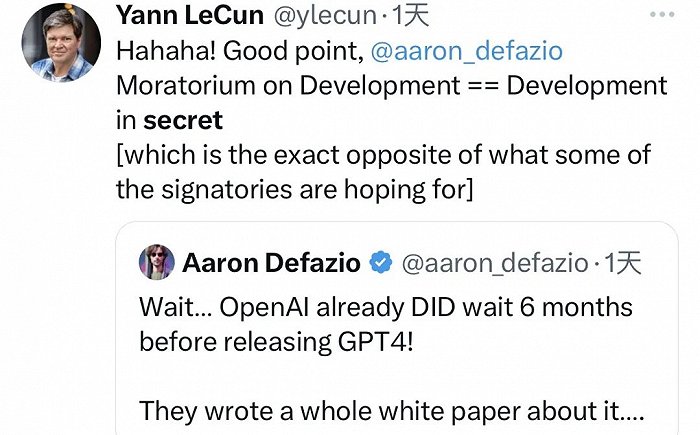

此前曾公開表示GPT模型沒有前途的圖靈獎得主LeCun表示,他沒簽名的原因是,公開信中所提及的“暫停研發”=“秘密研發”。他指出聯名信提出的倡議用處不大,并轉發另一位大佬的推文表示,該信充斥著夸張修辭和無效的政策方案。網友也表示,規則無法束縛那些最可能帶來風險的人,真正希望用AI搞破壞的人還是會偷偷研究。

也有不少人認為,一些公司主要是在利益驅動下提出此倡議,希望用這6個月的時間彎道超車,通過秘密研究重奪AI賽道的主動權。

徹底封禁派

還有一些人的態度更加堅決,他們要求永久封殺AI。

美國決策理論學家、機器智能研究機構科學家Eliezer Yudkowsky從2001年開始就活躍在AI領域。他在《時代周刊》發表文章稱,他沒有簽字的原因是,6個月的暫停期遠遠不夠,盡管公開信中已經闡述了AI的可能風險,他認為實際情況要嚴峻得多。他表示,公開信中所提到的“實現人類智能的AI”仍是一種過于樂觀的說法,未來AI的智能程度很有可能超越人類,AI發展會不知不覺地越過那條重要的警戒線。

文章探討了一個重要的可能性:人類創造出一個比自己聰明得多的AI后,該如何控制和管理它?最壞的但很有可能的結果是,人類將無法在AI控制的世界中活下來。

作者表示,雖然有一種可能性是,AI和人的欲望并不相同,也對人的存在毫不在乎。我們應當教會AI這種與人相處之道,以降低未來的潛在風險,但是如何做仍是最大難題。

但另一種可能性仍在存在,即AI可能會對人類抱有敵意。AI不可能被困在電腦里太久,一旦它們找到突圍之道,就如同一個比人類聰明數千萬倍的外星文明,可以輕而易舉地在地球上抹掉人類的蹤跡。而人類顯然還不知道,該如何應對這種可能的情況。

更重要的是,Yudkowsky強調,并非AI在具有意識時才能夠對抗人類。我們所構建的認知系統的計算過程太過于復雜,人類并不具有解碼AI運行具體過程的能力。在這種情況下,到底是人創造了AI,還是AI自己創造了自己?

他還表示,微軟CEO在新必應發布后向谷歌示威,這種做法是非常不明智的,完全對AI的風險視若無睹,而只著眼于科技巨頭間的競爭,對人類的未來非常危險。

文章要求,在全球范圍內無限期地中止所有新的大語言模型的訓練,并關閉全部大型GPU集群,即使是政府和軍隊也不能例外。

各國政府:逐步規范AI

AI的發展之快超出了所有人的想象,各國政府也開始加快制定政策的速度。

上周,意大利個人數據保護局要求OpenAI暫停處理意大利用戶的數據。有關部門表示,“OpenAI這樣大規模收集和加工個人信息的活動是毫無法律根據的。此前ChatGPT就曾發生bug,用戶能看到其他用戶與ChatGPT聊天的標題。”由于ChatGPT的不實信息問題,他們還表示了對OpenAI缺乏使用年齡限制的擔憂。

英國也在上周提出了規范AI的計劃,盡管沒有對ChatGPT指名道姓,也沒有針對AI制定新規,但是政府要求各行各業的監管者應用其現行法律來規范AI。英國尤其強調了科技公司在開發AI時應遵循的原則,包括安全性、公開性、公平性、責任心和反壟斷性。

據CNBC報道,其他歐盟國家可能會對AI采取比英國更嚴格的規范措施。歐盟在規范科技公司方面常常走在最前線,此前就曾發布歐盟AI法案的草案,高度限制AI在重要基礎設施、教育、執法和司法體系中的使用。歐盟認為ChatGPT可能以高風險的方式被應用,可能會危及人類的基本權利和安全。

歐盟擁有非常多的AI專家,對OpenAI的規范也容易落實,因為OpenAI在歐盟沒有任何辦公室。德國聯邦數據保護委員Ulrich Kelber表示,德國也可能采取類似措施。法國和愛爾蘭的隱私政策官員也正在密切接觸意大利以求取經,但瑞典的數據保護局表示不會考慮對AI頒布禁令。

此外,美國總統拜登也于4月2日表示,AI的危險性仍然未可知,科技公司必須在保證產品的安全性基礎上才能進行產品發布。此外,他呼吁國會限制科技公司對個人數據的收集,以及面向青少年的廣告。

OpenAI:正式回應安全問題

對于外界的紛紛擾擾,OpenAI的CEO Sam Altman此前曾發推文表示,站在風暴中間,我很平靜。他提出一個好的AGI應該具備的三個特點,或許可以被視作對這場風波的另一種回應:

1.對齊超級智能的技術能力;

2.大多數領先AGI之間的充分協調;

3.一個有效的全球監管框架。

OpenAI的另一位創始人轉發表示支持,并附言,OpenAI的使命是確保AGI惠及全人類。

隨著事態的發酵,4月5日,OpenAI正式發表《我們的AI安全措施》,對隱私問題、青少年問題,不實信息問題等都作出了正式回應。文章表示,OpenAI一直致力于使AI工具保持安全性、并且對社會廣泛有益。確保AI系統的建造、部署和使用的安全性一直是他們的使命之一。

他們表示,在完成GPT-4的訓練后,OpenAI花了超過半年的時間強化模型的安全和協調性,才最終發布了GPT-4。他們通過嚴格內部測試和外部專家反饋改進模型的行為,通過強化學習技術建立廣泛的安全和監控系統。

關于隱私政策,OpenAI表示所有數據都用來提升GPT模型以幫助使用者,而非用于銷售服務、廣告等營利性互動。ChatGPT靠與人對話來進行學習,OpenAI的一些訓練數據包括公共網絡上的私人信息 ,但他們希望模型學習的是世界,而不是個人。因此,OpenAI正致力于從訓練數據中盡可能刪除個人信息,調整模型以拒絕獲取私人個人信息的請求,并響應個人對于刪除其個人信息的要求。

關于青少年,只有18歲以上、或13歲以上且父母批準的人才能夠使用其AI工具。OpenAI決不允許技術被用來產出仇恨、騷擾、暴力或成人內容。GPT-4相比于GPT-3.5,對不合規內容的響應請求減少了82%。OpenAI稱已經付出了巨大的努力,以最小化模型生成對兒童有害內容的潛力。例如,當用戶嘗試上傳兒童性虐待材料時,OpenAI會阻止并向國家失蹤和被剝削兒童中心報告。

關于不實信息,OpenAI表示如今的大型語言模型是憑借已有信息對接下來可能出現的word pattern進行預測,已有信息里面包括用戶輸入的不實信息,因此ChatGPT基于錯誤信息作出的回答里也會出現不實信息。目前GPT-4的信息準確度,已經較GPT-3.5提高了40%。在用戶注冊ChatGPT之前,OpenAI就告知不實信息產生的可能性。他們將繼續推動準確度的提升,并持續教育公眾AI工具的局限性。

OpenAI承諾,今后也會投入更多資源和努力,持續提升AI工具的安全性。

02 如何治理AI?

正如Arthur C. Clarke所提出,任何足夠先進的技術,都與魔法無異。我們如何創造、利用、維護有史以來最強大的“魔法”?如何在教導“魔法”的同時,“馴服”魔法?

面臨AI魔法的到來,人工智能應該具有哪些倫理價值?如何在創新和規范之間平衡AI治理?

作為國際人工智能協會(AAAI)執行委員會成員、人工智能專家,托比·沃爾什(Toby Walsh)一直致力于研究如何讓人工智能更好地應用于人類生活。在《2062:終結》一書中,他對上述問題給出了他的思考。對于AI的規范,或許我們可以從他對于人工智能的看法中,窺見些許方向。

有限制地注入意識或欲望

我們沒有測量意識的儀器,大腦中也沒有任何一個部分單獨負責意識。對于機器而言,意識與欲望是把雙刃劍,界定相當重要。

舉個反面例子,假設阿爾法圍棋意識覺醒,將圍棋拋之腦后,而打算玩網絡撲克掙點錢,那他的欲望將驅使他走向研發初衷的反方向。

但至少現在,它并沒有意識,甚至不知道自己在玩圍棋,只是在計算贏得一場游戲的概率。沒有意識的情況下,他也不會出現電影中所描述的,產生了接管地球的欲望。

同樣,意識包含道德。正面角度而言,為了表現的有道德,計算機需要能夠反思其決定。復雜的社會能夠運轉,與我們能夠意識到他人在想什么十分相關。

機器的意識產生途徑有三:被編程而產生、從復雜性中出現、被習得而學會。人類至少有三分之二的把握,能夠控制機器的意識發展。

如果機器不是僵尸智能(意識、智力分開學習狀態),那么,我們必須做出一些具有挑戰性的道德決策。

當涉及道德行為時,有意識的機器勝過無意識的機器,它可以反思自己的行動,從過去到現在,再到未來。

阿西莫夫曾在1942年提出了著名的機器人守則,或許可供未來規范與立法等參考:

第一條:機器人不得傷害人類,或袖手旁觀坐視人類受到傷害。

第二條:除非違背第一法則,機器人必須負責人類的命令。

第三條:在不違背第一法則及第二法則的情況下,機器人必須保護自己。

然而,這些法則仍然具有局限性。比如說,采取行動會傷害一個人;不采取行動會傷害另外一個人,會發生什么呢?兩個人發出沖突指令,又會發生什么呢?經典的電車難題:選擇撞上孩童還是無人的汽車,便挑戰了阿西莫夫法則。

在此基礎上,第四條法則提出,它優先性高于前三條法則:

第零守則:機器人不得傷害人類整體,或因不作為使人類整體受到傷害。

就此而言,我們或許需要機器人具備并保持一個比人類更高的道德水準。比如,自動駕駛汽車永遠不超速;獨立自主且具有武裝力量的無人機永遠按照國際人道主義法進行活動等。無論是個人、企業還是國家,在使用、經營、鍛煉期間,都需要以人為本。

提高機器工作透明度

在機器做決策過程中,透明度也是至關重要的。我們希望機器不僅能夠做出公平的決定,還能夠在做出決定時保持透明度,以建立我們對其公平性的信心。這是當今人工智能系統所面臨的主要挑戰。

機器如果能夠合理解釋決策,將有助于在出錯時及時糾正,同時,彌補人類決策的缺失。

合理的疼痛訓練

讓機器體會到合理的痛苦,或許是可嘗試的,就像人類被灼燒會迅速將手拿開,這一行為具有積極的學習作用。

但同時,我們也應當考慮到,如果我們給予機器感知痛苦的能力,他們是否也會感知恐懼,從而防止自己受傷、防止自己嘗試危險工作呢?

那么,使用機器,從機器人角度出發的道德準則,就需要再加一條。

克服機器偏見與算法歧視

在語言翻譯中,曾出現這樣一種問題:土耳其語中,“o”既可以是“他”,也可以是“她”,但當翻譯回英語時,卻會自動產生性別之分,如“她是個護士”、“他是個士兵”等。

同時,如Compas程序,在進行數據訓練后,會針對性預測哪些囚犯會再次犯罪,這對未來的最壞結果預測,本身就不具有公平性,給人打上不可原諒的標簽。

在計算機算法識別中,還存在著膚色問題。黑人女孩難以被計算機識別,這可能源于有偏見的數據測試。在人臉識別的數據集中,男性占77.5%,白人占83.5%。很明顯,更廣泛的人群需要被容納到測試空間中。

此類書面文本中長期存在的偏見與印象需要被統一規劃與避免。當我們將問題移交給機器時,我們需要仔細考慮既定環境中,如何定義公平。

界定AI涉足的隱私領域

在人工智能時代,維護私人生活所必需的隱私將成為一個重大的挑戰。

谷歌公司首席互聯網科學絕Vint Cerf曾表示“隱私本質上可能是一種非正常需求”。他所說的并不全無道理,人工智能的到來必將帶來更加嚴密的審查,實時追蹤一切與電子相關的事情。即便一家公司可以負責任地將數字隱秘起來,有可能會出現隱私保護失控的問題。物質上的獨立空間、精神上的獨立思考與選擇,都需要法律進行合理界定。

因此,有關隱私,AI需要被限制,公司需要有限制,個人也一樣。

當地時間3月31日,意大利個人數據保護局宣布,將暫時封鎖意大利境內訪問ChatGPT的途徑,同時,審查OpenAI在最近一次網絡安全事件中收集的個人信息等問題。

建立AI工作的勞動保護

自20世紀以來,經濟學家定期對工作做出預測,“技術性失業”常常出現在他們的預測結果當中。更有美國學者預測,47%的工作,即將被取代。即便已有無數打工人自嘲飯碗不保,還是很少有人真心希望自己被加速“下班”。

人工智能對于工作本身,既是問題,又是答案。

AI的到來,將完成更多崗位任務,釋放時間與精力給個人用于生活中的各個方面。但在知識宇宙膨脹時代,所有人都能平等地享受到不休眠機器人所創造的財富嗎?機器人如果跨越成管理層,對于個人的工作進行評判打分,人性化的指標又何在?工作空間全方位“被”觀察,又能否給人喘息的余地?

機器人踏入職場,或許也需要相應的《勞動保護法》,保護AI,也保護人類。

辯證看待生命的期限與不朽

人工智能能夠帶“我們”走向永生嗎?

從醫學角度而言,人工智能能夠帶我們了解身體運轉、如何工作、如何返老還童,硅谷富豪已經在親身實踐身體極限。同時,我們也面臨著大部分生命終結的原因:衰老。如果人工智能真能突破這一點,我們也需要重新考慮:沒有終點的生活,需要我們重新考慮存在的意義。

另一方面,如果我們注定會衰老而離開,人工智能是否有權利帶著我們的記憶“活”下去?這是生命與道德的雙重考量。

無論哪種“不朽”,都不得不歸結到社會轉變上來。誰能夠通過某種方式獲得“不朽”的機會呢?貧富差距又能否導致壽命長短差異從而陷入死循環?

生命是短暫的,這是它美感的一部分,當AI有能力逆轉一點點的局勢,我們就不得不重視起來,是否應當限制AI賦予生命全新的意義;如何將AI提供的生命機會公平地提供給所有人。

警惕AI武器的濫用

戰場上,如果人類也能被機器人替代,那新的軍備競賽將開始打響。普遍存在的致命自主武器,如果從人為控制發射全部替換成機器人,那這將是一場高科技的較量。“干凈”的技術戰場,卻也隱藏著一絲可怕的火藥味。

完全自主的武器將更加強大。比如,無人機空軍,飛行員不用冒生命危險作戰,作戰優勢將不斷提高。不需要食物供應與薪酬,還能全天候作戰,永遠服從、執行命令,這樣的軍事夢想,完美而可怕。

當用代碼可以指揮數以千計的作戰武器,戰爭工業化也隨之到來。戰爭的各類道德性借口,“為了家人、親友的不得已”都將土崩瓦解。那么,只需要出無人機進行對抗卻無人傷亡的干凈戰場,真的存在嗎?并不一定。

致命性自主武器的威懾力,從不只是幾行代碼那么簡單。控制武器,比制造武器要求更加謹慎精準。當AI能控制大規模殺傷性武器,即便只有萬分之一的“誤差”,人類也會感到威懾與恐懼。

機器人出現在汽車工廠等地方,具有充分的理由,但出現在戰場中卻不太明智。戰場本身就充滿了不確定性與混亂,無論是機器、人類抑或是代碼,都有犯錯幾率。武器的速度極快,出錯的可能性會隨之增加,人類、土地都不該用“誤傷”來解釋。

所以,合理利用自主武器,遵守國際人道主義法至關重要。這還涉及到一個“責任差距”問題,如果致命性自主武器真的出錯,誰來負責?誰被審判?

在國際人工智能聯合會議上,已有公開信呼吁聯合國禁止進攻性自主武器。迄今為止,已有多個國家呼吁聯合國禁止致命性自主武器。部分類似的《特定常規武器公約》中,也應當對應考慮AI加入后的新情況。

References:

[1]《2062:終結》Toby Walsh

[2]Elon Musk Signs Open Letter Urging AI Labs to Pump the Brakes, TIME, https://time.com/6266679/musk-ai-open-letter/

[3] OpenAI CEO Sam Altman Says AI will Reshape Society, Acknowledges Risks:'A Little Bit Scared of This', abcNEWS,https://abcnews.go.com/amp/Technology/openai-ceo-sam-altman-ai-reshape-society-acknowledges/story?id=97897122

[4]Pausing AI Developments Isn't Enough. We Need to Shut it All Down, TIME,https://time.com/6266923/ai-eliezer-yudkowsky-open-letter-not-enough/

[5]A Canadian godfather of AI calls for a ‘pause’ on the technology he helped create, Financial post, https://financialpost.com/technology/canadian-godfather-ai-pause-technology-helped-create

[6]“Godfather of artificial intelligence” weighs in on the past and potential of AI, CBS NEWS, https://www.cbsnews.com/news/godfather-of-artificial-intelligence-weighs-in-on-the-past-and-potential-of-artificial-intelligence/

[7]Italy became the first Western country to ban ChatGPT. Here's what other countries are doing, CNBC, https://www.cnbc.com/amp/2023/04/04/italy-has-banned-chatgpt-heres-what-other-countries-are-doing.html

[8]Bill Gates says calls to pause AI won't solve challenges, REUTERS, https://www.reuters.com/technology/bill-gates-says-calls-pause-ai-wont-solve-challenges-2023-04-04/

[9]Biden says tech companies must ensure AI products are safe, AP NEWS, https://apnews.com/article/joe-biden-artificial-intelligence-science-technology-chatgpt-6948df344041ef1e794d199595bf69e9

[10] Our approach to AI safety, OpenAI, https://openai.com/blog/our-approach-to-ai-safety