文|Julien Grimaud/Pavla Debeljak/Frank Yates

編輯|Meister Xia

導讀

ChatGPT是一款聊天機器人,它可以產生令人信服和自然流暢的文本。但是,教育工作者質疑學生使用這類聊天機器人是否存在風險。學生可能會利用ChatGPT為他們寫作文,甚至于作弊。教育界應該為此擔憂嗎?他們應該如何應對呢?

一覽:

- ChatGPT是一種聊天機器人,即一種人工智能程序,既能模擬與人對話,還會寫出自然流暢的文章。

- 教育界對學生使用聊天機器人表示擔憂,學生可能會使用ChatGPT寫老師布置的作文。

- 雖然有軟件工具可以判斷文章是否是由聊天機器人寫的,但是不可能做到100%的準確。

- 識別一篇文章是否是由機器人寫的,一般的方法是檢查文中奇怪的措辭、不自然的語法或抄襲的段落。

- 聊天機器人若合理使用,無論在教學中還是職場上都能發(fā)揮巨大作用。

聊天機器人并非新興事物,已經存在了幾十年[1, 2],早已在客戶服務、營銷、游戲、教育等領域廣泛使用。第一個聊天機器人ELIZA是20世紀60年代由麻省理工學院的人工智能實驗室開發(fā)的,目的是模擬心理治療師,使用自然語言回答用戶輸入的心理咨詢問題。60年過去了,如今的聊天機器人越來越先進,能使用人工智能來理解用戶復雜的輸入,并提供更自然、更智能的對話。隨著技術的不斷進步,聊天機器人將繼續(xù)拓展其使用空間,能在醫(yī)療保健到金融等各種行業(yè)里大顯身手[3]。

ChatGPT由舊金山的OpenAI公司開發(fā),發(fā)布于2022年11月30日,是一款聊天機器人,一個能模擬人類對話的計算機程序。GPT原文全稱是Generative Pre-trained Transformer——“可生成預培訓轉換器”。預培訓是一種人工智能(AI)模型,即先對機器人進行大量文本數據訓練,進而使其可以響應用戶的輸入要求。ChatGPT之所以受歡迎,是因為它確實能夠寫出令人信服和引人入勝的文章,這使它在寫作、自動化客戶服務和自然語言處理等領域備受歡迎[4]。由此教育界開始擔心如果學生使用聊天機器人,是否會引發(fā)風險。近日,OpenAI發(fā)布了GPT-4。新版本比上一個版本先進多少?還有待觀察。

01、學生會惡意使用聊天機器人嗎?

作弊是教育中一個由來已久的問題[5]。基于人工智能的聊天機器人為有意作弊者提供了一條新的途徑。使用它既可以完成平時作業(yè),也可用于考試舞弊。學生可由此偷懶,對教師提供的教學材料置之不理,讓機器人解數學題和多項選擇題。聊天機器人的使用很簡單,其操作與谷歌、必應等搜索引擎類似,輸入問題即可得到答案(這兩個搜索引擎不久后或將引入GPT[6])。這種操作是否算作作弊?只能由教師決定。

“作弊是學校教育中一個由來已久的問題,而基于人工智能的聊天機器人為有意作弊者提供了一條新的途徑。”

更有甚者,一些聊天機器人能解決專業(yè)性強的問題。例如,DeepL Translate是一種基于人工智能的在線語言翻譯服務,它能又快又好地將文章、網站文檔翻譯成多種語言。有些聊天機器人能編寫計算機代碼,比如Codebots和Autocode。雖然這些聊天機器人的設計初衷是善意的,旨在幫助用戶解決乏味重復的任務,但它們很可能會被學生用于作弊。

除了回答簡短的問題外,經過預培訓的人工智能機器人還能寫出看似學識淵博的文章。Quillbot、Paperpal或WordAI等寫作工具已經問世數年,可以神奇地將一篇寫得不好的手稿更改為一篇頗為像樣的學術論文。它們還能篡改他人文章,并逃避抄襲檢測。更令人擔憂的是,一些聊天機器人只要人工輸入一些簡短的提示,就能夠在幾秒鐘內生成長篇大論,與人工創(chuàng)作的作品看似相差無幾。

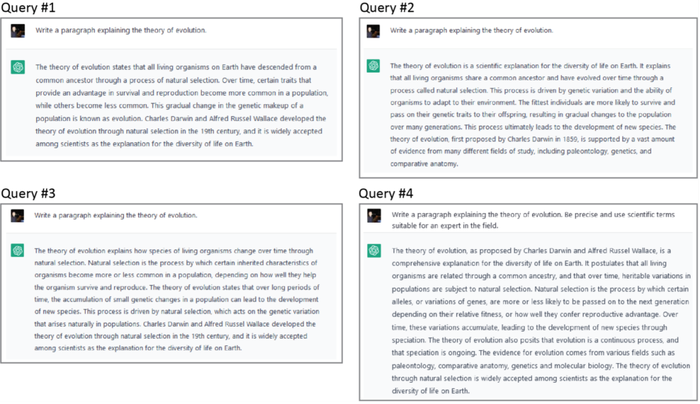

在ChatGPT中,學生可以輕松地調整各種參數,例如回復的內容長短、內容的隨機性水平,或者所用的人工智能模型變體。生成的論文學生可以按原樣使用,也可以親自進一步修改,只需幾分鐘就能輕松地寫出一篇扎實的文章。此外,重復多次為聊天機器人提供相同的題目,能生成多個不同版本(見圖1)以供學生選擇。學生可以拼湊各個版本中的部分內容,寫出一篇獨特的文章。如果學生這樣使用機器人,目前是無法100%準確地檢測出來的。

圖片來源:PI France

注:向ChatGPT詢問進化論。我們反復要求ChatGPT寫一段關于進化論的文章。在前三次,我們提出的問題是一樣的,但ChatGPT每次的回答都略有不同。在第四次,我們要求機器人啟動專家模式,由其結果可以看出該軟件使用專業(yè)術語的水平相當的高。

02、擔心什么?

另一方面,就算學生不想抄襲,但一旦將聊天機器人生成的答案作為自己的作業(yè)提交,且不援引聊天機器人引用的資料作為參考來源,則抄襲實際上已經在他們沒有意識到的情況下產生了。此類抄襲尤其難以檢測,因為許多聊天機器人模型都包含隨機性元素。此外,聊天機器人雖然能寫出原創(chuàng)的句子或段落,但也會生成與原始資料高度類似的語句。因此,用戶在使用聊天機器人時要避免不小心涉嫌抄襲。鑒于一些聊天機器人能專門查找參考文獻[7],很快我們可能會看到寫作機器人使用參考文獻機器人來寫文章!

但是機器人畢竟與人類不同,由于聊天機器人理解對話上下文的能力有限,可能會給出錯誤的答案或誤導性的信息。此外,聊天機器人可能會表現(xiàn)出偏見歧視,例如以某種固定老套的方式或某種性別來使用語言,甚至可能給出侮辱性或有爭議的錯誤信息[8-10]。微軟于2016年發(fā)布的Tay聊天機器人是一個人工智能項目,旨在與推特上的人互動,從與真人的對話中學習,并隨著時間的推移越變越聰明。然而在發(fā)布幾周后,Tay因為開始發(fā)表有爭議和冒犯性的言論被下線[11]。

圖片來源:OpenAI

注:使用DALL E(OpenAI)生成的圖像,人工輸入的要求是“以Henri Rovel的風格,生成機器人學生和教授在教室的油畫”。

最令人擔憂的是,聊天機器人的使用會導致學生獨立思考能力的喪失。隨著聊天機器人越來越先進,能夠為學生回答各種問題,不需要他們自己思考。這樣學生的學習會變得很被動,既損害教學效果,也導致學生創(chuàng)造力下降。

03、教育界應該為此擔憂嗎?

聊天機器人看似新穎,令人興奮,但這項技術已經存在了幾十年。你可能在不知情的情況下常常閱讀人工智能寫的文章。例如,美聯(lián)社和《華盛頓郵報》等新聞機構使用聊天機器人寫作短新聞由來已久。美聯(lián)社在2014年開始使用“語言大師Wordsmith” [12],而《華盛頓郵報》至少從2017年起就一直在使用內部聊天機器人Heliograf[13]。

在過去幾年里,聊天機器人提供的答案質量大幅提高。現(xiàn)在人工智能生成的文章即使在學術界,也很難與人類親自創(chuàng)作的文章區(qū)分開來[14]。雖然在學術界遭到反對,但ChatGPT在一些科學論文中甚至被列為正式作者[15],盡管這樣做富于挑釁意味。

“新聞機構早就在使用聊天機器人生成短篇報道。”

此外,雖然聊天機器人可以(或者說肯定會)被用來作弊[16, 17],但它們只是學生的又一個工具。即便在ChatGPT爆火之前,學生也有多種方法可以做作業(yè)作弊,比如從同學處復制答案,使用在線資源查找和抄襲答案,甚至雇人做作業(yè)。換句話說:只要想作弊,辦法總是有的。

04、教育界該如何應對?

教育界的應對應該是采取新的規(guī)定,禁止學生濫用聊天機器人。這可以作為一門課程的要求,或者作為學校對全體學生的要求[18]。新規(guī)定會對學生起到威懾作用,讓學生害怕作弊被發(fā)現(xiàn)的處理后果,還能提高學生和老師對聊天機器人這一問題的認識。然而,僅靠規(guī)定很難完全解決問題。

改變學生的測試方式是否可行?由于其知識庫有限,聊天機器人一般不容易解決新穎、有創(chuàng)意的任務。但這種方案也有兩個問題。一方面,基于人工智能的技術,尤其是聊天機器人,是一個突飛猛進,技術日新月異的領域。只要軟件更新,老師調整作業(yè)形式的努力便會前功盡棄。另一方面,傳統(tǒng)的測驗和作文雖然能輕松地通過聊天機器人獲得答案,但它們依舊是有效的教學手段,能檢驗出學生對知識點的理解、分析、概述能力 [19]。教師改進作業(yè)布置方式固然好,但不應是應對聊天機器人的唯一方案。

另一個有待探索的解決方案是統(tǒng)計水印[20]。統(tǒng)計水印是一種用于在數字信號中嵌入隱藏消息或數據的數字技術。對于聊天機器人,水印可以是一組由非隨機概率選擇的單詞或短語,人眼無法看出,但計算機可以識別,由此便可檢出聊天機器人生成的文本。

“統(tǒng)計水印是一種用于在數字信號中嵌入隱藏消息或數據的數字技術。”

然而,統(tǒng)計水印存在多方面劣勢,嚴重限制了其在教學中的使用。科技公司可能不愿意在軟件中實施統(tǒng)計水印,因為如果他們的聊天機器人被用于恐怖主義或網絡欺詐等行為,會帶來聲譽和法律風險。此外,只有當作弊的學生大段地復制粘貼聊天機器人文本時,統(tǒng)計水印才有效。如果聊天機器人生成的文章被學生編輯過,或者文本太短無法進行統(tǒng)計分析,則水印法無效。

05、如何檢測人工智能生成的文章?

檢測人工智能生成的文章的另一種方法是尋找文中不自然的措辭和語法。人工智能算法通常在表達想法的自然性方面有缺陷,因此可能會生成太長或太短的句子。此外,聊天機器人可能會缺乏自然的思想意識流,會在上下文中不恰當的使用某些單詞或短語。換句話說,生成的內容缺乏人類寫作的深度和微妙度[21],對于長篇文章來說尤其如此。上文提到聊天機器人的使用可能會涉嫌抄襲。因此,只要使用最常見的剽竊檢測引擎,就能輕松地檢測出人工智能生成的文本 [22]。

此外,還可以通過尋找“統(tǒng)計簽名”來檢測人工智能生成的文本。聊天機器人的基本邏輯是基于用戶輸入的題目,根據詞語在同類語境中出現(xiàn)頻次的高低選擇措辭,每個詞都是在概率上最有可能與上一個詞共同使用的詞語。這一點與人寫作不同。人寫作時,會根據自己的認知能力而不是根據概率來寫,會產生不常見的單詞聯(lián)想,但依舊符合邏輯。簡單地說,與聊天機器人相比,人類的回答會更具創(chuàng)造性。基于這一規(guī)律,麻省理工學院和哈佛大學使用openAI的語言模型GPT 2聯(lián)合開發(fā)了巨型語言模型測試室(GLTR)。我們用了幾篇學生寫的短文和ChatGPT生成的短文來測試GLTR,結果GLTR輕而易舉地分辨出了學生的作品(見下面的方框)!

自GLTR問世以來,許多其他人工智能檢測程序也陸續(xù)出現(xiàn),例如OpenAI Detector(發(fā)布于GLTR之后不久,原理類似),還有GPTZero——一個由一名大學生于2023年創(chuàng)建的企業(yè)。未來將有更多檢測聊天機器人文本的新工具出現(xiàn),更適合教育工作者的需求,類似于現(xiàn)在的抄襲檢測引擎。

06、是作弊還是聊天?

最后,我們不要忘記,大多數學生還是愿意在不作弊的情況下完成作業(yè)的。首要的預防措施應該是讓學生體會課程內容的重要性、有用性和趣味性,激勵學生的學習熱情[23]。計算器并沒有讓數學老師失業(yè),谷歌并沒有導致學校停課。同樣,教育界肯定會適應聊天機器人。盡管對機器人的擔憂是合理的,但很快機器人的價值會在許多方面凸顯。在適當的框架和指導下,聊天機器人可以成為強大的教學和學習助手,以及企業(yè)的寶貴工具。

因此,教育工作者應該主動讓學生熟悉聊天機器人,幫助他們了解這項技術的潛力和局限性,并教他們如何以高效、負責任和合乎道德的方式使用聊天機器人。

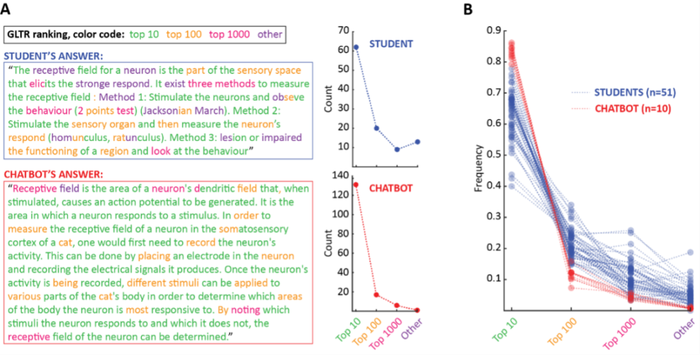

用統(tǒng)計簽名檢測聊天機器人生成的文章

實驗設計:在巴黎學習生物技術學院2022年秋季學期開設的神經科學課堂上,我們收集了51名學生對以下問題的書面回答:“簡要地闡述術語‘感受域’的定義,然后解釋如何測量貓體感皮層神經元的感受域。”這個問題來自一場開卷考試,學生可在家中登錄課程網站,在規(guī)定時間內完成。同時,我們要求ChatGPT對以上問題提供10個答案,然后使用GLTR來比較學生和聊天機器人回答的統(tǒng)計簽名。

GLTR的工作原理:GLTR會按順序查看文本中每個詞,對比GPT-2聊天機器人(舊版ChatGPT)的選擇和學生的選擇。以這句話為例——Biology is great! (“生物學很棒!”),第三個詞是great“很棒”,但如果讓聊天機器人選擇第三個詞,它可能會首選a“一個”,因為在其單詞庫中a的排名最高,而great的排名是第126位。隨后GLTR會根據每個詞的排名生成直方圖,由此構成一種簡單的統(tǒng)計簽名判別法:GPT-2生成的文本中,高排名單詞比例會很高,但人類寫出的文本中,低排名單詞的比例會更高。

A欄:兩個示例答案,一個來自學生,另一個來自ChatGPT。不同顏色對應著單詞排名的高低。右邊的直方圖顯示了二者的統(tǒng)計簽名。可見人類的作答比聊天機器人包含更多的低排名單詞。

B欄:我們將51名學生的直方圖(藍色)和聊天機器人10個答案的直方圖(紅色)放在同一個坐標系里,再次發(fā)現(xiàn)學生的寫作和ChatGPT生成文本之間有明顯的差異。換句話說,僅憑對統(tǒng)計簽名的目測,就能確鑿地判斷學生沒有使用ChatGPT來回答這個問題。

參考資料

1. Ina. The History Of Chatbots – From ELIZA to ChatGPT. In Onlim.com. Published 03-15-2022. Retrieved 01–19- 2023.

2. Thorbecke C. Chatbots: A long and complicated history. In CNN business. Published 08-20-2022. Retrieved 01- 19–2023.

3. Marr B. What Does ChatGPT Really Mean For Businesses? In Forbes. Published 12-28-2022. Retrieved 01–19- 2023.

4. Timothy M. 11 Things You Can Do With ChatGPT. In MakeUseOf.com. Published 12-20-2022. Retrieved 01–19- 2023.

5. Bushway A, Nash WR (1977). School Cheating Behavior. Review of Educational Research, 47(4), 623–632.

6. Holmes A. Microsoft and OpenAI Working on ChatGPT-Powered Bing in Challenge to Google. In The Information. Published 01-03-2023. Retrieved 01-19-2023.

7. Vincze J (2017). Virtual Reference Librarians (Chatbots). Library Hi Tech News 34(4), 5–8.

8. Feine J et al. (2020). Gender Bias in Chatbot Design. Conversations 2019. Lecture Notes in Computer Science, vol 11970. Springer, Cham.

9. Haroun O. Racist Chatbots &Sexist Robo-Recruiters: Decoding Algorithmic Bias. In The AI Journal. Published 10-11-2023. Retrieved 01-19-2023.

10. Biddle S. The Internet’s New Favorite AI Proposes Torturing Iranians and Surveilling Mosques. In The Intercept. Published 12-08-2022. Retrieved 01-19-2023.

11. Vinvent J. Twitter taught Microsoft’s AI chatbot to be a racist asshole in less than a day. In The Verge. Published 03-24-2016. Retrieved 01-19-2023.

12. Miller R. AP’s ‘robot journalists’ are writing their own stories now. In The Verge. Posted 01-29-2015. Retreived 01-19-2023.

13. Moses L. The Washington Post’s robot reporter has published 850 articles in the past year. In Digiday.com. Posted 09-14-2017. Retreived 01-19-2023.

14. Else H (2023). Abstracts written by ChatGPT fool scientists. Nature, 613(7944), 423.

15. Stokel-Walker C (2023). ChatGPT listed as author on research papers: many scientists disapprove. Nature (retrieved online ahead of print on 01-23-2023).

16. Gordon B. North Carolina Professors Catch Students Cheating With ChatGPT. In Government Technology. Published 01-12-2023. Retrieved 01-19-2023.

17. Nolan B. Two professors who say they caught students cheating on essays with ChatGPT explain why AI plagiarism can be hard to prove. In Insider. Published 01-14-2023. Retrieved 01-19-2023.

18. Johnson A. ChatGPT In Schools: Here’s Where It’s Banned—And How It Could Potentially Help Students. In Forbes. Published 01-18-2023. Retrieved 01-19-2023.

19. Krathwohl DR (2002). A revision of Bloom’s taxonomy: An overview. Theory into practice, 41(4), 212–218.

20. Aaronson S. My AI Safety Lecture for UT Effective Altruism. In Shtetl-Optimized, The Blog of Scott Aaronson. Posted 11-29-2022. Retreived 01-19-2023.

21. Bogost I. ChatGPT Is Dumber Than You Think. In The Atlantic. Published 12-07-2022. Retrieved 01-19-2023.

22. Mollenkamp D. Can Anti-Plagiarism Tools Detect When AI Chatbots Write Student Essays? In EdSurge. Published 12-21-2022. Retrieved 01-19-2023.

23. Shrestha G (2020). Importance of Motivation in Education. International Journal of Science and Research, 9(3), 91–93.

關于作者

Julien Grimaud,巴黎學習生物技術學院生命科學助理教授

Pavla Debeljak,巴黎學習生物技術學院生物信息學助理教授

Frank Yates,巴黎學習生物技術學院工程學院研究主任