文|極智GeeTech

在智能輔助駕駛蓬勃發(fā)展的當下,這項技術(shù)既需要創(chuàng)新活力,也需要回歸本質(zhì)的定力。

近日,特斯拉副總裁陶琳發(fā)布了馬斯克近期對智能輔助駕駛技術(shù)路線的判斷。馬斯克從道路系統(tǒng)設(shè)計的根本邏輯出發(fā),闡述了特斯拉堅持純視覺方案的理論基礎(chǔ)。

他指出,全球道路交通體系本質(zhì)上是圍繞智能體的視覺感知能力構(gòu)建的,無論是人類的生物神經(jīng)網(wǎng)絡(luò)還是人工智能系統(tǒng),都依賴“眼睛”這一核心感知器官獲取環(huán)境信息。基于這一認知,人工智能結(jié)合數(shù)字神經(jīng)網(wǎng)絡(luò)和攝像頭的技術(shù)組合,才是與現(xiàn)有道路系統(tǒng)最為匹配的自動駕駛解決方案。

他同時認為,一個模型扎根于現(xiàn)實是非常重要的,從未見過有人打破物理定律。對于任何一個AI,必須建立在現(xiàn)實的基礎(chǔ)上,這些有助于確保模型的真實性和準確性,但這是一個常常被忽視的話題。只有遵循物理定律,AI才能實現(xiàn)真正的智能。

對于汽車,用戶對“安全抵達”與“舒適體驗”的期待始終如一,這促使我們不斷思考:智能輔助駕駛的差異化創(chuàng)新是否應(yīng)聚焦于表層功能,還是應(yīng)回歸本質(zhì)需求,以標準化能力推動普惠價值?

智能輔助駕駛“第一性原理”

談到智能輔助駕駛“第一性原理”,很多人第一時間會想到馬斯克的理論——“以人類視覺認知為根基,通過海量真實路況數(shù)據(jù)訓(xùn)練神經(jīng)網(wǎng)絡(luò),用純視覺感知實現(xiàn)類人駕駛決策的通用化自動駕駛系統(tǒng)。”

一直以來,馬斯克批評激光雷達技術(shù)在智能輔助駕駛領(lǐng)域的應(yīng)用價值。“道路系統(tǒng)并非為從眼睛發(fā)射激光而設(shè)計”,這一表述凸顯了他對激光雷達技術(shù)適用性的根本性質(zhì)疑。當攝像頭與激光雷達同時工作時,系統(tǒng)往往面臨信息沖突的困擾——究竟應(yīng)該相信視覺傳感器還是激光測距數(shù)據(jù),這種技術(shù)層面的不確定性,可能會導(dǎo)致交通事故的發(fā)生。

“第一性原理”最早源自古希臘哲學(xué),亞里士多德在其著作《形而上學(xué)》中首次提出了這一概念。他認為,第一性原理是“不可被進一步推導(dǎo)的最基本的命題或假設(shè)”,即所有知識和推理的終極基礎(chǔ)。

簡單來說,每個系統(tǒng)中存在一個最基本的命題,它不能被違背或刪除。其核心思想是:回歸事物的本質(zhì),剖析最基本的原理和假設(shè),從而構(gòu)建新的認知框架或解決方案。

任何系統(tǒng)都是有邊界的,所謂邊界就是這個系統(tǒng)的前提條件,也叫前提假設(shè)。對于這個系統(tǒng),這些“前提假設(shè)”會成為“不證自明”的概念和命題,而這些概念命題就是這個系統(tǒng)的“第一性原理”。

對于“第一性原理”的理解,我們可以看作是任何一個系統(tǒng)的“關(guān)鍵設(shè)定”。這個設(shè)定既不是誰家自創(chuàng)的,也不是獨家專有的,而是一個需要費盡心力去探索和思考的邏輯起點。

這個邏輯起點,只需要你信還是不信,想明白還是想不明白,此后的行動能否一以貫之的按照這個邏輯起點去貫徹執(zhí)行,能夠篤定相信這一邏輯起點所打造的系統(tǒng)的“真理性”。

手機行業(yè)的演進史為汽車智能化提供了絕佳啟示。基帶芯片作為手機通信能力的核心,始終以“穩(wěn)定傳輸”為第一性原理,無論用戶是商務(wù)精英還是學(xué)生群體,其對通話質(zhì)量的需求本質(zhì)趨同。

智能輔助駕駛同樣遵循這一邏輯——從A點到B點的安全、舒適、高效,是人類對出行最基礎(chǔ)且不可妥協(xié)的需求。智能輔助駕駛無法像音樂或香氛一樣,為不同用戶提供差異化體驗,它的終極使命是成為像基帶一樣可靠的基礎(chǔ)設(shè)施。

這一認知正在重塑行業(yè)對“智駕平權(quán)”的理解。真正的平權(quán)應(yīng)聚焦于功能價值的標準化收斂:通過統(tǒng)一的安全標準、普適的舒適性定義、可復(fù)制的效率優(yōu)化,讓智能輔助駕駛能力像手機通話功能一樣,成為所有車型的“默認配置”。

特斯拉的“西進運動”

就像19世紀初,大批美國的早期創(chuàng)業(yè)者們闖入西部開疆擴土,開啟了持續(xù)半個世紀的西進運動。馬斯克帶著特斯拉開啟了乘用車智能輔助駕駛的狂飆突進。

特斯拉的這場“西進運動”從2014年至今大致可以分為三個階段。2014年至2016年的外部合作期,2016年至2019年的自研過渡期,以及2019年至今的全面自研期。

第一階段,特斯拉先后與Mobileye和英偉達建立過合作,經(jīng)歷了從“軟硬件外采”到“硬件外采、軟件自研”的艱難歷程。

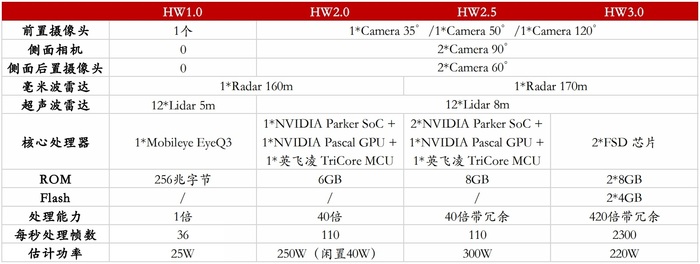

2014年,特斯拉在AutoPilot上并無多少積累,選擇了當時市面上能達到L2輔助駕駛能力的視覺方案——Mobileye的EyeQ3。AI算力是只有0.25 TOPS,只能支持1個前視攝像頭、1個毫米波雷達和12個超聲波雷達,從而實現(xiàn)了自適應(yīng)巡航、前車碰撞預(yù)警以及方向盤自主變道等功能。

基于這一軟硬件外采方案,特斯拉于2014年10月發(fā)布AutoPilot 1.0版本和硬件模塊Hardware 1.0。

馬斯克從一開始就對Mobileye的黑盒交付(將軟硬件封裝起來,不對主機廠開放)十分不滿。借著2016年那場全球首例自動駕駛致死車禍,特斯拉果斷拋棄Mobileye,轉(zhuǎn)向英偉達的懷抱。

2016年10月,特斯拉發(fā)布AutoPilot 2.0和硬件模塊HW 2.0。整體算力達到10 TOPS,幾乎是Mobileye EyeQ3的整整40倍。外接傳感器包含了8個攝像頭、1個毫米波雷達、12個超聲波雷達。

第二階段,特斯拉在和英偉達熱絡(luò)之際,就開始了智駕芯片的自研之路。這就是后面被公眾所熟知的FSD芯片,單片AI算力72 TOPS,采用高度定制的CPU+GPU+ASIC架構(gòu),其中ASIC是由兩個神經(jīng)網(wǎng)絡(luò)處理單元NPU組成,專門用作視覺圖形處理。

2019年,特斯拉推出FSD軟件系統(tǒng)和HW 3.0。相比較前一代HW 2.5(算力20 TOPS),HW 3.0平臺上配備了兩顆FSD芯片達到144 TOPS,系統(tǒng)算力增長了7倍多。

也是在這一階段,除了芯片自研之外,特斯拉招募了大批人工智能算法專家,開始感知和決策當中引入深度學(xué)習(xí)算法。為適應(yīng)AI算法所需要的大規(guī)模數(shù)據(jù)處理和標注,特斯拉還引入了上千人的標注團隊并不斷擴容數(shù)據(jù)中心。

以至于在2019年4月的Autonomy Day上,馬斯克首次公布了超級計算機Dojo的研發(fā)計劃。

至此,特斯拉進入第三階段——全面自研階段。

作為量產(chǎn)的智能輔助駕駛方案,在特斯拉這里,形成一個基于AI三要素——即算法、數(shù)據(jù)和算力,所形成的數(shù)據(jù)驅(qū)動的開發(fā)范式。

數(shù)據(jù),來自量產(chǎn)車型和采集車回傳的大量駕駛場景數(shù)據(jù)和駕駛行為數(shù)據(jù),由于當時的算法采用監(jiān)督學(xué)習(xí),十分依賴高質(zhì)量的標注數(shù)據(jù),所以數(shù)據(jù)標注一直是一個“人工大于智能”的苦活累活。同時也包括大量仿真構(gòu)造的虛擬場景數(shù)據(jù),用于真實世界里很難遇到的Corner Cases(極端場景)或長尾場景。

算力,車端計算單元主要是運行智駕算法的AI芯片。同時也包括在云端進行算法訓(xùn)練和數(shù)據(jù)處理的AI芯片,市面上主要是被英偉達的GPU所壟斷,而特斯拉的Dojo則更進一步為智能輔助駕駛視覺模型訓(xùn)練設(shè)計。

算法,是由云端計算平臺根據(jù)大規(guī)模數(shù)據(jù)學(xué)習(xí)所訓(xùn)練出來的神經(jīng)網(wǎng)絡(luò),然后經(jīng)過微調(diào)、蒸餾等方式部署到車端,形成一個可以處理感知理解、認知決策和預(yù)測規(guī)劃等任務(wù)的復(fù)雜神經(jīng)網(wǎng)絡(luò)系統(tǒng)。

2021年的Tesla AI Day具有里程碑意義,公開了特斯拉在之前數(shù)年時間的技術(shù)探索。以智駕系統(tǒng)最重要的感知算法為例,特斯拉的智駕算法也經(jīng)歷了數(shù)次迭代過程。

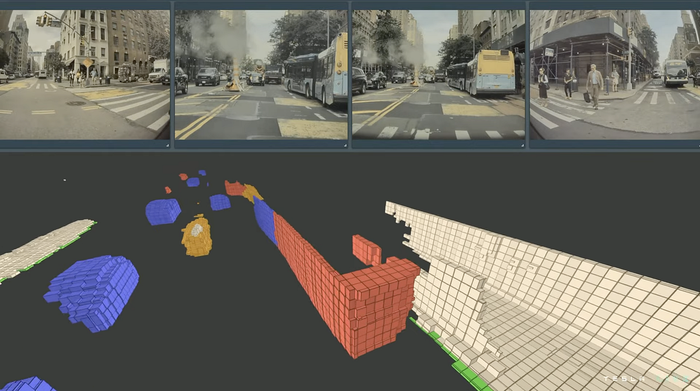

感知的核心任務(wù)是識別和理解外部環(huán)境。特斯拉的8個攝像頭可以不停地采集到外部世界的2D圖像,但這不足以構(gòu)造出人類駕駛所需要的始終延續(xù)的車道線、疾馳而過的車輛等信息。通過感知神經(jīng)網(wǎng)絡(luò),特斯拉構(gòu)建出一個表征真實世界的3D向量空間。

作為特斯拉車型上唯一的傳感器,攝像頭存在兩個固有缺陷:第一,沒有深度信息,所接受的只是一連串二維圖像;第二,易受夜晚、大雨、濃霧等極端天氣影響,獲取的圖像質(zhì)量直線下降,可能導(dǎo)致識別錯誤或者漏檢。

為了彌補這兩個缺陷,特斯拉推出了基于Transfomer的BEV(Bird’s Eye View,鳥瞰視角)算法棧,這也就是外界所津津樂道的“BEV+Transformer”,讓視覺感知網(wǎng)絡(luò)獲得了測速、測距能力,能把車輛周圍攝像頭拍攝的2D畫面,拼接成一張完整的俯視地圖,讓車輛“看到”周圍360度的全景,從而獲得感知。

也就是在這一年,特斯拉宣布北美地區(qū)的新款Model 3和Model Y將不再配備毫米波雷達,轉(zhuǎn)而采用全新的純視覺技術(shù),以支持AutoPilot駕駛輔助系統(tǒng)。

到了2022年的AI Day上,特斯拉在感知模塊進一步升級了占用網(wǎng)絡(luò)(Occupancy Network),可以在BEV+Transformer感知框架的基礎(chǔ)上實現(xiàn)通用能力更強的3D空間感知。形象理解,就是把車輛周圍空間劃分成無數(shù)個小方格,像樂高積木一樣標記每個格子是否被物體占據(jù),讓汽車僅靠攝像頭就可獲取周圍環(huán)境的深度信息,實現(xiàn)高分辨率的三維感知與重建。

這之后,特斯拉又放出了“端到端”的全新方案。此前,在特斯拉智駕軟件算法中,感知、規(guī)劃、控制等模塊一直是相對獨立,其中感知算法是神經(jīng)網(wǎng)絡(luò)化最為徹底的,而規(guī)控算法則帶有大量的人工規(guī)則代碼。而特斯拉在“端到端”方案之前,已經(jīng)嘗試將神經(jīng)網(wǎng)絡(luò)用于自車軌跡預(yù)測、規(guī)劃當中。

而端到端,就是這一進程的最極致表現(xiàn),完全采用一張神經(jīng)網(wǎng)絡(luò),將感知、規(guī)控和執(zhí)行鏈接起來,“圖像進、動作出”,像極了人類老司機開車的過程,在做出加減速、轉(zhuǎn)向燈動作時幾乎是跟感知同時且不假思索。而之前的所謂模塊化,則像極了新手司機先要判斷下看到了什么、思考下這個情況應(yīng)該怎么辦,然后再告訴手和腳要怎么行動。

端到端方案和模塊化方案高下立判,但實現(xiàn)端到端并不容易。2023年,特斯拉開始嘗試端到端方案的測試,系統(tǒng)運行速度比原方案更快,甚至直接刪掉了30萬行人工代碼,輔之以端到端系統(tǒng)自己學(xué)到的人類的開車知識。

同一年,特斯拉車型全面取消了超聲波雷達配置,由高清攝像頭所取代,采用100%純視覺方案實現(xiàn)車輛的智能輔助駕駛。

2024年,特斯拉FSD V12版本正式發(fā)布,采用端到端架構(gòu)和數(shù)據(jù)驅(qū)動的技術(shù)范式,再次引領(lǐng)了潮水的走向。

從特斯拉的發(fā)展歷程來看,馬斯克似乎更多解決的是車輛在復(fù)雜環(huán)境中的有效行動,需要的不僅僅是視覺給出的條件反射,更需要在不同交通狀況下形成較強的適應(yīng)能力和應(yīng)變能力,因此要不斷訓(xùn)練車輛對于當下環(huán)境的認知和反應(yīng),促使車輛在“所見所感”和“如何反應(yīng)”之間發(fā)展出人類般的智能化水平。

在爭議中持續(xù)前行

事實上,對于堅持純視覺方案的特斯拉駕駛輔助系統(tǒng)AutoPilot,至少在美國本土市場一直存在比較大的爭議。

特斯拉已經(jīng)向主導(dǎo)美國國家公路安全的美國國家公路交通安全管理局(NHTSA)提交了和使用AutoPilot有關(guān)的1000多起事故。其中,美國媒體《華爾街日報》就列舉的222起事故中,有31起事故是未能識別出障礙物而導(dǎo)致整車未能做出反應(yīng)所導(dǎo)致的。

純視覺方案有一個比較大的缺陷在于識別前方的靜態(tài)物體上存在局限性。對于靜態(tài)物體的識別,?攝像頭往往無法準確區(qū)分路牌、?紅綠燈架、?橋墩等障礙物與實際需要避讓的靜態(tài)物體。

2022年,一位特斯拉前員工約翰·貝納爾幫助《華爾街日報》分析一場交通事故時表示,面對路上出現(xiàn)的一輛被撞壞的汽車,AutoPilot中的一個攝像頭識別出了它,但是另外一個沒有識別出。基于這樣的輸入,AutoPilot選擇讓車輛繼續(xù)前進,最后車輛全速地撞了上去。

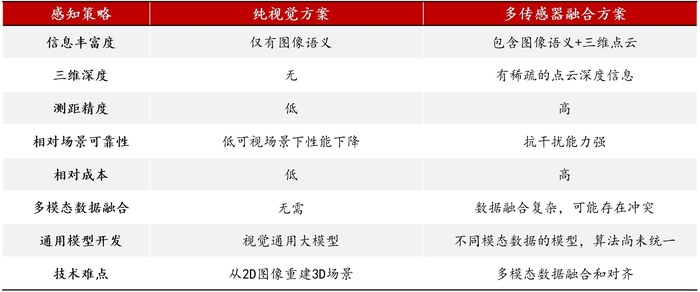

純視覺方案主要依靠攝像頭來收集周邊道路場景的信息,然后通過預(yù)先設(shè)置的算法來識別周邊環(huán)境并做出判斷。這種方案有最大的兩個優(yōu)點:成本較低且貼近人眼邏輯。按照馬斯克的觀點,通過對攝像頭的持續(xù)優(yōu)化,可以將攝像頭無限接近人類的眼睛。只要人類駕駛員可以開車,那么特斯拉的純視覺方案也可以。

但特斯拉或者其他純視覺方案的堅持者忽略了一個事實:由于攝像頭接受的是反射光,因此受到光的影響比較大。也就是說,如果遇到了暴雨、夜間等環(huán)境情況,攝像頭就會和人類駕駛員一樣,在感知上存在比較大的挑戰(zhàn)。

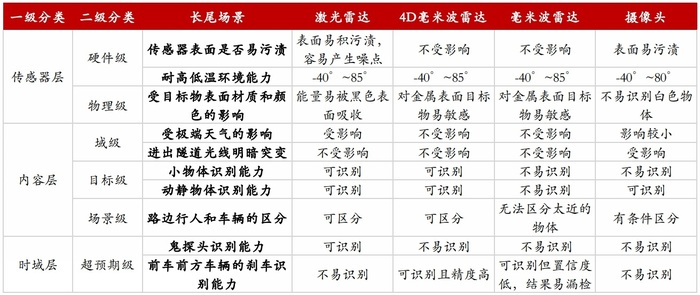

由于拿掉了激光雷達這個關(guān)鍵傳感器,純視覺方案在遠距離識別場景、生成點云方面的確會有一些欠缺,如何通過視覺傳感器和其他基礎(chǔ)雷達來彌補激光雷達的缺失,是特斯拉、小鵬這些純視覺方案堅持者要考慮的首要問題。

和純視覺方案并行的是多傳感器融合方案,其本質(zhì)是希望來融合純視覺和雷達(主要是激光雷達)各自的優(yōu)勢,來達成更好的對周邊態(tài)勢情況的感知。和攝像頭相比,激光雷達再探測距離、精度和實時性方面有比較明顯的優(yōu)勢,同時在抗干擾方面也有一定的優(yōu)勢。

重要的是,多數(shù)據(jù)融合在搭載激光雷達的同時,也會同時布置多個攝像頭,因此純視覺方案在感知上的優(yōu)勢,多傳感器融合方案也不會落下。

而激光雷達、毫米波雷達等傳感器也并非完美。作為一種主動傳感器,激光雷達在測量遠距離的復(fù)雜地形或障礙物可能發(fā)生多次反射,導(dǎo)致信號混疊,使得原來的信號失真,或者產(chǎn)生錯誤,難以準確識別甚至誤識別真實目標。

激光雷達對于天氣狀況非常敏感,但穿透雨霧主要依靠的是毫米波雷達。遇到雨雪霧等極端天氣就會在傳感器附近幾米內(nèi)形成一團噪點,并且不能穿透這些透明障礙物看到霧氣后面的目標,從而“致盲”。

另外一個問題就是數(shù)據(jù)融合。純視覺方案下,自動駕駛控制器只需要考慮攝像頭的數(shù)據(jù)輸入;但是在多傳感器融合的方案中,控制器需要同時對攝像頭和激光雷達的輸入進行融合判斷。

這不僅大大增加了控制器需要處理的數(shù)據(jù)量,而且更為關(guān)鍵的是,如果當控制器發(fā)現(xiàn)攝像頭和激光雷達的輸入由于誤報存在相沖突時,采信哪個輸入源也將對整個自動駕駛系統(tǒng)帶來不小的考驗。

純視覺與多傳感器融合兩種方案自誕生以來,一直被質(zhì)疑,一直在成長。可以發(fā)現(xiàn),并不存在一種完美方案能夠解決所有問題。純視覺方案需要在軟件算法層面彌補攝像頭的不足,而多傳感器融合方案則需要承擔(dān)偏高的硬件成本以及開發(fā)能夠融合多傳感器數(shù)據(jù)的算法,同時兩者均需要采用高算力的芯片來完成數(shù)據(jù)計算。

智能輔助駕駛?cè)允且粭l充滿不確定性的道路,一切尚無定論。目前各家所認定的“第一性原理”都是基于自身視角形成的認知框架,目前仍停留在“假設(shè)”階段,遠未成為行業(yè)公認的普適準則。

真正的“第一性原理”并非冰冷的傳感器或算法,而是人類對駕駛安全的永恒追求。在整個駕駛體系中,人類始終是自身安全的第一責(zé)任人,機器永遠無法完全取代人類的決策地位。在這條通往未知的路上,技術(shù)的光芒或許會照亮前路,但唯有對安全底線的敬畏與堅守,才是穿透迷霧、指引方向的北極星。